什麼是「熵」?

第一次看到這個字的人其實很難對此字做出直覺上的理解,但這個字對於理工背景出身的來說並不陌生。之所以不陌生,大多是從克勞休斯經驗準則──熱力學第二定律接觸到此字的。這個定律說明了在一個熱力學系統若達成了熱平衡狀態時,該系統的「熵」會達到最大值。在「熵」達到最大值時,該系統的自由能將會達到最小值。

相信絕大多數的人依然看不懂上面這一段話到底在講什麼。用淺顯易懂的白話文來解釋「熵」的話,就是「一個系統亂度的物理量」。

假設我的房間很亂,那我房間的「熵」肯定很高。

假設現在有一個巨人把我的「房間」拿起來就像搖雪克杯一樣上下搖晃,可想而知我的房間只會越來越亂。但隨著搖晃次數越多,你會發現房間內的「混亂程度」將趨於一個穩定狀態,最後你很難分辨出哪一個狀態是被搖比較多次數後的結果。為什麼房間被搖晃之後只會越來越亂?難道不會越來越整齊嗎?你若心中所想的答案是「當然不會」,那麼恭喜你已掌握了熵的特性。

下次再度被爸媽罵房間很亂的時候,不妨跟他們說「房間亂很正常,因為必須服從熱力學第二定律」。

也是因為「熵」有上述特性,人們傾向將熵描述為屬於能量性質的巨觀物理量。但「熵」這個概念一開始只是條經驗定律,當時人們無法對此進行解釋。直到美國科學家吉布斯(Josiah Willard Gibbs)在熱力學領域的畢生努力,才從微觀角度奠定近代統計力學理解熵的理論基礎。將一杯熱水放在另一杯冷水旁邊,為什麼最後兩杯都會變溫水?而不是熱水更熱冷水更冰?這對常人來說是白癡問題,但往往都是因為有吉布斯這樣的天才對白癡問題的思索,人類才會有現在的科學成就。

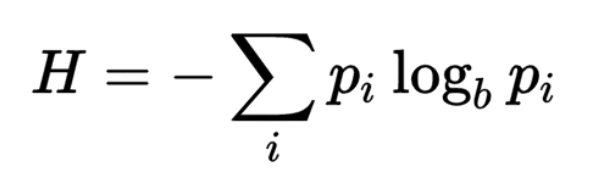

由於我們從巨觀角度觀察並無法明確掌握一個系統的微觀狀態,像這樣的一個不確定性就藉由機率分佈如正則系綜 (canonical ensemble)來做量化表示。透過機率分布來對古典系統熵的不連續表示公式如下圖:

公式中「Kb」表波茲曼常數,而「Pi」為觀察者量測到系統處在狀態「i」時的機率分佈。

既然熱力學第二定律是條經驗定律,那麼這個「現象」若發生在其它非熱力學的領域其實也不令人訝異。例如台北市長柯文哲在TEDxTaipei 2013演講中的投影片也用到了這個經驗定律,透過這個定律來解釋他從醫後所得到的生死觀。

在生物學領域,薛丁格在《生命是什麼》中就提出了「生物就是負熵過程」這樣的概念。因為生物的天性會努力抗拒死亡,死亡為一種讓熵變大的過程。

觀察到這個經驗定律的當然也不只有西方,其實在《道德經》當中第十六章也有一段相當相似的描述:

「夫物芸芸,各復歸其根。歸根曰靜,靜曰復命。」

「天之道,損有餘而補不足。」

說真的,我其實都一直認為古人早就把這世界上所有道理都講完了,我們只是用另一種敘述方式再詮釋一次而已。

前面舉了那麼多各領域的例子無非是為了讓大家能意會到什麼是「熵」,但「熵」這個概念在人類社會真正出現突破性的應用其實是在資訊領域。隨著通訊理論的日漸成熟與多元發展,在1940年代一位美國科學家香農(Claude Elwood Shannon)在通訊領域也發現到相似的特性,從此熵的概念被引進到資訊領域,我們稱之為「信息熵」或「資訊熵」。資訊熵在通訊領域被用來描述雜訊干擾有用資訊的影響程度,資訊熵的機率分佈型也被發現相當類似於熱力學熵,這個機率分佈的相似性直到1957年才被證實其實不只相似而其實是相等。

自古以來「語言」跟「數學」一向是八竿子打不著的兩個領域,直到香農的論文《通訊的數學原理》出世後人們才找到了將「文字」跟「數字」串聯在一起的方法。那麼,香農的洞見到底是什麼?他是怎麼將資訊給量化的呢?過去我們評斷資訊量大小的方式很可能是透過書本的厚度、文字個數的多寡,若是電子檔或影音檔的話我們可能會用檔案容量大小或是影音時間的長短來做判斷。但香農為「資訊含量」提出了另一個觀點:「資訊的含量大小,在於它克服了多少不確定性。」

對於這個觀點我舉一個例子來解釋:

1.今天是禮拜_。

2.今天是禮拜_,可以在家好好休息。

我們知道若要讓句子讀起來通順,「禮拜」後面能接的字只有那幾個而已,差不多有「一」、「二」、「三」、「四」、「五」、「六」、「日」、「天」這八個。但第二句因為後半段「可以在家好好休息」導致能讓第二句讀起來通順的選擇變少了只剩下「六」、「日」、「天」這三個。可用的選擇變少也代表克服了一定程度的不確定性,資訊熵也跟著越低;若可用的選擇越多,資訊熵也跟著越高。香農對資訊熵定義的公式如下:

就算不懂數學,你也會發現上述公式與我一開始所提的古典系統熵的不連續表示公式有極高的相似性。

現在有了這個資訊熵公式我們就可以來衡量資訊量的大小了,我講一個香農本人提出了例子。

一個完美公正的硬幣,每次拋出正面的機率P都是1/2,若你告訴我這次拋硬幣結果是正面,那這個消息的資訊量就是

-log2(1/2)= 1

既然正反面出現的機率都是1/2,那這串消息不管多長,資訊熵都是1/2*1+1/2*1 = 1。香農規定資訊量的單位是「bit」,這個資訊熵就是1bit。

那如果這個硬幣並不公正呢?

假設這個不公正硬幣拋出正面的機率是60%,拋出反面的機率是40%,那麼資訊熵就會是-[0.4*log2(0.4)+0.6*log2(0.6)]=0.971bit。透過下面這張圖我們就可以發現,當正反面出現機率均等都是50%的時候有最大的資訊熵為1bit。如下圖所示:

0.

公正硬幣資訊熵最大值的特性已經告訴你了,那麼一顆公正骰子六個面各自的機率在什麼樣的分配下資訊熵會達到最大值呢?我想你已經猜到了,就是六個面出現機率均等的時候。

現在我手上有40枚公正的10元硬幣,以乾坤一擲的手法往前一撒,猜幾枚正面朝上會最接近真實分佈?若你猜一半朝上一半朝下,再次恭喜你!你已經掌握了「最大熵原理(Maximum entropy principle, MEP)。」

本文第一段有提到「在「熵」達到最大值時,該系統的自由能將會達到最小值。」,這個其實就是最大熵原理。

取平均值這道理不是很簡單嘛?有必要搞那麼複雜弄一個什麼最大熵原理?「平均」是人們面對問題常見的解決方式,但透過資訊熵我們學到了若要選擇一個分佈作為最佳解,最客觀的選擇就是有最大信息熵的分佈,這也解釋了當我們面對未知狀況選擇取平均的直覺是對的。同時資訊熵也給了我們一個方法把問題給量化,才能用來解決其他更困難複雜的問題。

面對環境的未知與不確定性,最大熵原理(Maximum Entropy Principle)給了我們一個做決策的依據。當選擇了資訊熵最大的分配方式,你就保留了最大的不確定性,藉此來將風險降到最低。例如你正在觀察15檔股票,這15檔股票你都同樣看好,那麼把資金平均分配買進就是風險最小的方法。同樣,股票價格的簡單平均線(S.M.A.)也是如此,價格均線並非只反應出平均買進成本而已。

簡單平均背後的意義其實是很美麗的。

留言列表

留言列表